Ultimamente si sente parlare sempre più spesso di Crawl Budget e della sua ottimizzazione per permettere al Googlbot di navigare tutto il nostro sito web. ma cos’è esattamente il Crawl Budget?

Cos’è il Crawl Budget?

Il Crawl Budget è un vero e proprio “budget” che Google assegna al nostro sito web, detto in maniera ancora più semplice: quanto Google è disposto a spendere, in termini di tempo e risorse, per navigare il nostro sito web.

In pratica Google assegna un budget giornaliero (settimanale, mensile) di scansione al nostro sito, spendendolo per navigare le nostre pagine web, noi possiamo intervenire facilitandogli la vita ed evitando, allo stesso tempo, di fargli sprecare risorse preziose.

Ottimizzazione del Crawl Budget: consigli

Immaginiamo il nostro sito come un supermercato, poi immaginiamo un cliente che ha a disposizione poco tempo per acquistare quello di cui si ha bisogno. Solitamente i prodotti sono ben organizzati in corsie in modo da non far perdere del tempo a chi sta facendo la spesa, ed è giusto così. Il nostro sito dovrebbe fare lo stesso e dovrebbe essere ben organizzato e facile da capire, bisogna allo stesso tempo evitare di far vedere a Google le pagine che non devono essere inserite nell’indice e quindi inutili.

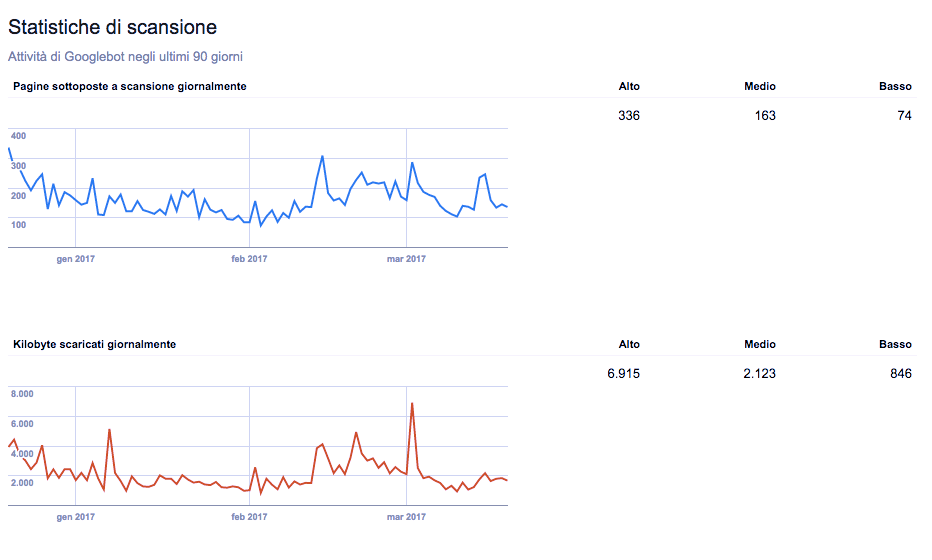

Attraverso Search Console è possibile capire quanti kb e file vengono “scaricati” ogni giorno da Googlebot, più è alto questo valore più vuol dire che al motore di ricerca piace il nostro sito web e che quindi vuole i nostri contenuti.

Come interpretare i valori di Search Console e migliorare?

Quali valori bisogna tenere in considerazione in Search Console per migliorare ed ottimizzare il Crawl Budget?

- Tempo trascorso per il download: ovvero il tempo che Googlebot impiega nello scaricare le nostre pagine web, bisogna mantenere basso questo valore per evitare di far perdere troppo tempo allo spider del motore di ricerca.

- Pagine sottoposte a scansione giornalmente: più è alto il numero di pagine che Googlebot scansiona ogni giorno, più significa che il nostro sito è apprezzato, ovviamente se il numero di pagine del nostro sito corrisponde, o si avvicina, al numero di pagine navigate/scaricate ogni giorno è un segnale positivo, se troppo alto potrebbe essere anche un segnale negativo.

Ma come ottimizzare il crawl budget?

Tornando all’esempio del supermecato, dobbiamo evitare che Googlebot perda tempo a girare per le corsie del nostro sito web che non sono “idonee” all’indicizzazione, ovvero quelle pagine che non devono comparire nelle SERP (Search Engine Result Page) e che hanno uno scopo puramente funzionale (Il pannello WordPress, per esempio), come possiamo farlo? Attraverso il file robots.txt, tramite questo documento è possibile fornire indicazioni agli spider dei motori di ricerca, indicando quali sono le pagine che non devono visitare, un esempio? La Cookie policy è da escludere perché è sempre duplicata e uguale su più siti.

Basterà indicare nel robots.txt :

User-agent: *

Disallow: /cookie-policy/

Cosa influisce sul Crawl Budget e come aumentarlo?

Il budget che Google assegna al nostro sito è molte volte influenzato dalla frequenza di aggiornamento dello stesso, in pratica quanti nuovi contenuti vengono creati ogni giorno, ogni settimana e/o mese. Su un sito di notizie il budget assegnato sarà sicuramente più grande di un blog che viene aggiornato una volta alla settimana.

Un altro valore che dal mio punto di vista influisce sull’aumento del Crawl Budget è il trust, ovvero quanta fiducia ha Google in noi. Se un sito riceve tanti link vuol dire che quel contenuto è importante e Google va ad effettuare una scansione poi, successivamente, tutto il sito web e con maggiore frequenza perché i contenuti sono apprezzati dagli altri webmaster e di conseguenza potrebbero essere utili per gli utenti che effettuano una ricerca in Google.

Conclusioni sul Crawl Budget e consigli finali

L’ottimizzazione del Crawl Budget è dal mio punto di vista molto importante proprio per migliorare l’esperienza di navigazione dei bot e degli utenti stessi, perché se uno spider riesce a capire con facilità la struttura del nostro sito web, allora anche i navigatori avranno una vita facile!

Leave a Reply